2017 年 3 月 22 日下午,Facebook 人工智能研究院院长、纽约大学终身教授 Yann LeCun 在清华大学大礼堂为校内师生以及慕名而来的业内人士呈现了一场主题为《深度学习与人工智能的未来(Deep Learning and the Future of AI)》的精彩公开课。

随着 AlphaGo 事件的不断发酵,神经网络成为时下人工智能产学领域万众瞩目的研究焦点,也成为普罗大众的热门话题。事实上,神经网络作为一种算法模型,很早就已经被广泛关注和研究,也曾长时间内陷入发展突破的低潮期。不过,在以 Geoffrey Hinton、Yann LeCun 和 Yoshua Bengio 为代表的众多神经网络活跃研究者的坚持和努力下,人们对卷积神经网络的研究得到开拓性进展,深度学习进入大众视野,神经网络终于在 2006 年迎来了复兴。

Yann LeCun 作为深度学习运动的领军人物,Facebook 人工智能研究院院长兼纽约大学教授,其一举一动都能引发业界的广泛关注。这次,由清华大学经济管理学院发起,清华 x-lab、Facebook 主办的主题讲座邀请了 Yann LeCun,作为《创新与创业:硅谷洞察》学分课程中的第一节公开课的讲者,针对深度学习技术的历史发展进程与人工智能的未来趋势进行了深入的解析,并分享了一些精彩观点。

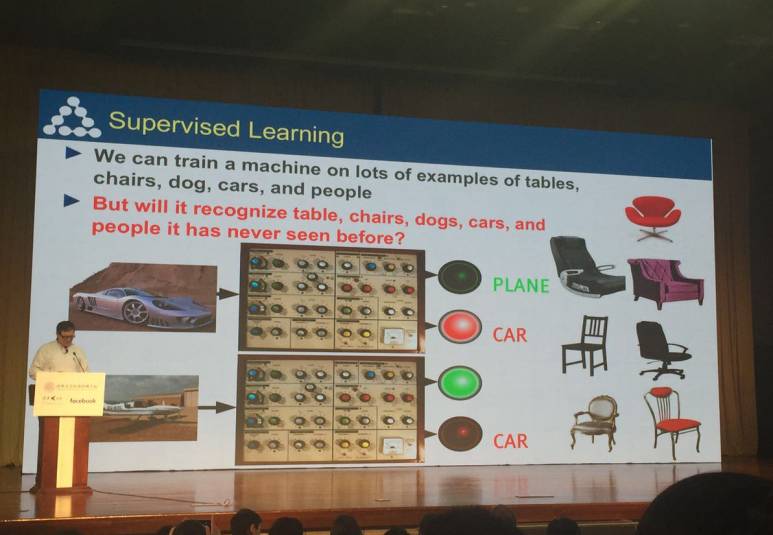

一开场,Yann LeCun 就通过回顾去年的 AlphaGo 事件引出今天讲座的主题《深度学习与人工智能的未来》,并向在场观众抛出了一个问题:人类可以利用大量的样本去训练机器,可是机器能够识别出它从未见过的事物吗?

带着这个问题,Yann LeCun 讲述了深度学习的发展过程以及他个人在领域内的探索历程。

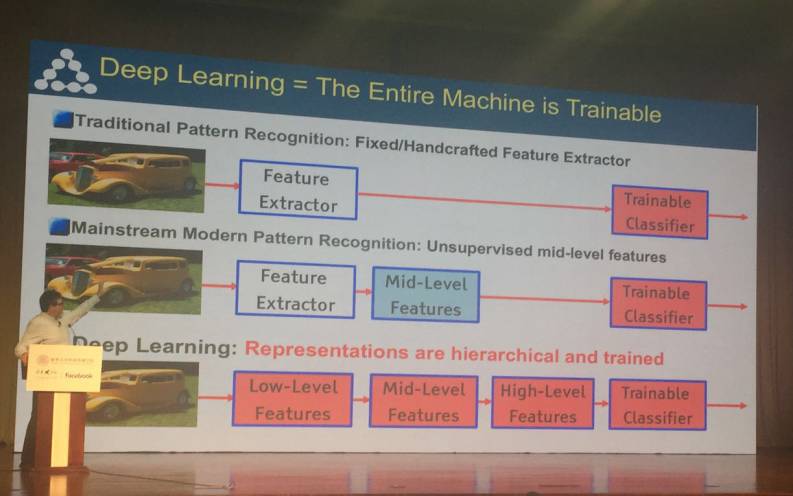

首先,Yann LeCun 回顾了 1957 年的感知器以及 50 年代末期的传统模式识别模型,并对传统模式识别、主流现代模式识别以及深度学习特征提取方式进行了比对;随后,他又对多层神经网络、反向传播算法、卷积神经网络结构(归一化——滤波器组——非线性计算——池化)等算法概念进行解析;并且展示了 1993 年完成的 LeNET1 Demo。

传统的模式识别是固定的/人工设计的特征提取器:数据→特征提取器→可训练的分类器

主流的现代模式识别使用了无监督的中级特征:数据→特征提取器→中级特征→可训练的分类器

深度学习方法则使用了训练出来的分层的表征:数据→低级特征→中级特征→高级特征→可训练的分类器

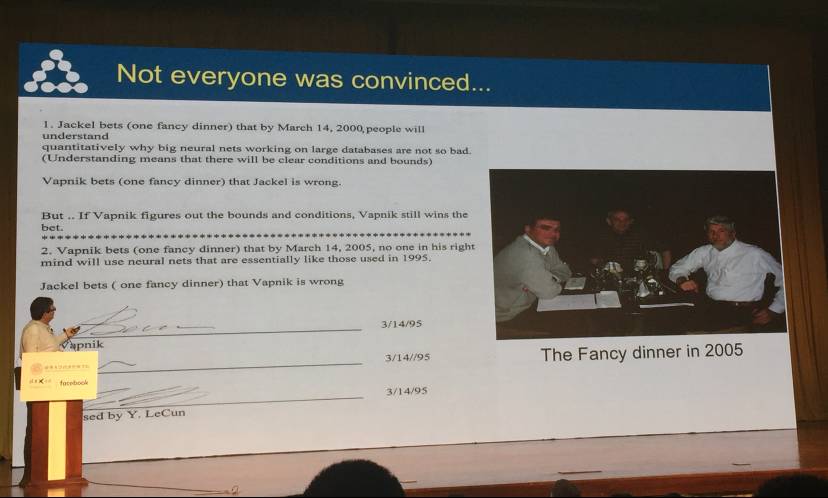

然而,当时业界仍对神经网络的未来仍存迟疑态度。Yann LeCun 举了一件关于他在贝尔实验室两位同事 Jackel (Larry Jackle现任 NVIDIA 机器学习顾问,曾在加拿大多轮多的一场 NVIDIA 的分享会讲过这个故事,并亲自协助完成了机器之心技术分析师对那场分享会的报道,感兴趣的读者可点击阅读原文查看此文章。)和 Vapnik 的趣事。在 1995 年的一次晚餐中,Jackel 曾经跟 Vapnik 打赌说,在 2000 年 3 月 14 日之前,人们将会理解大型神经网络,并给出明确的限定,事实证明,Jackel 的想法错了。而 Vapnik 打赌认为 2005 年 3 月 14 日后,没有人将会使用类似于 1995 年的那些神经网络,事实证明,Vapnik 也错了。

当事人 Larry Jackle 现任 NVIDIA 机器学习顾问,曾在加拿大多轮多的一场 NVIDIA 的分享会讲过这个故事,并亲自协助机器之心技术分析师对那场分享会的报道。

当卷积网络度过瓶颈期并得到人们的认可后,深度卷积网络开始用于解决各类计算机视觉问题,如目标识别;而随着网络深度的不断增加,产生了 VGG、GoogLeNet、ResNet 等深度卷积神经网络结构,它们可以用于图像识别、语义分割、ADAS 等众多场景。

这里,Yann LeCun 特别提到了 Facebook 提出的通用目标分割框架 Mask R-CNN,并展示了它在 COCO 数据集上的结果。(详情可见:)

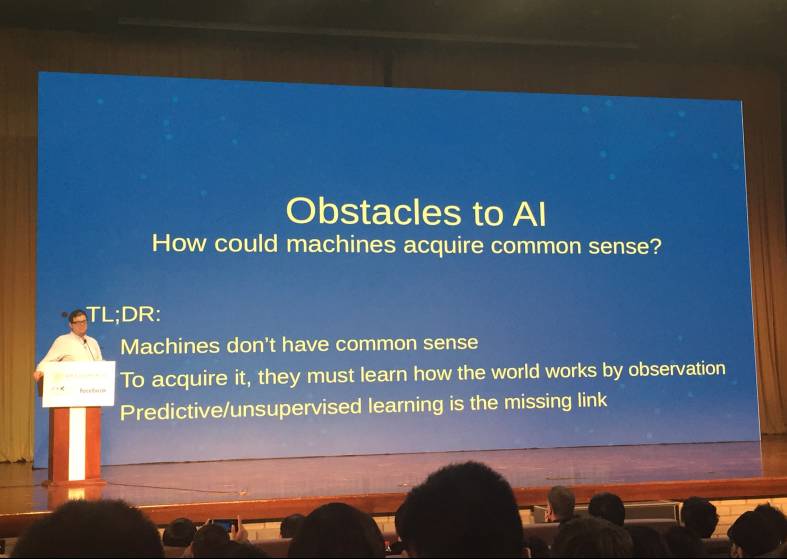

在为在场观众带来全新、深入的深度学习技术解析后,Yann LeCun 又探讨了人工智能领域存在的一个障碍和难点——怎样使机器获得「常识」呢?

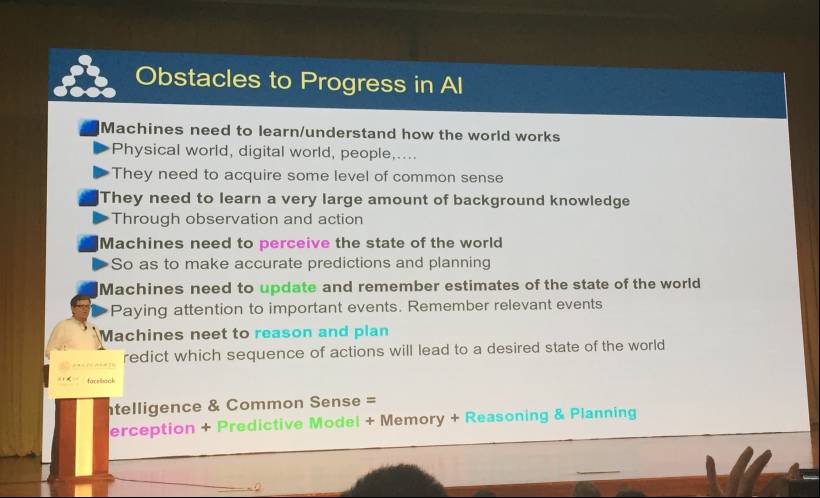

人工智能进步所面临的障碍:

机器需要学习/理解世界的工作方式:它们需要具备一定程度的常识

机器需要学习非常大量的背景知识:通过观察和行动

机器需要理解世界的状态:从而做出准确的预测和规划

机器学习更新和记忆对世界状态的估计:关注重要事件、记忆相关事件

机器需要推理和规划:预测哪些动作序列可以导致我们想要的世界状态

在人工智能领域,机器是如何跨越这种本质的障碍呢?Yann LeCun 给出了答案,即机器不仅需要学习、理解这个世界,学习大量的背景知识,还需要感知世界的状态,更新、记忆并评估世界的状态,而且还要有推理和计划的能力。这也就是所谓的「智能&常识=感知+预测模型+记忆+推理和规划」。

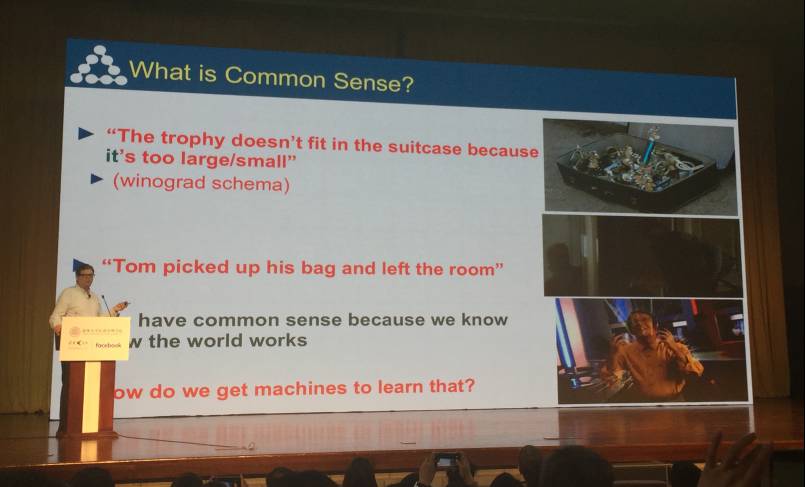

人们由于了解这个世界运作原理,所以会拥有常识,可是对于机器呢?它们能否具备所谓的「常识」呢?LeCun 举了几个例子进行说明。比如说「这个箱子装不下奖杯,因为它太大/太小了」这句话,当我们说「太大」时,我们知道「它」是奖杯;而当我们说「太小」时,那「它」就是「箱子」了。

转载请注明出处。

相关文章

相关文章 精彩导读

精彩导读 热门资讯

热门资讯 关注我们

关注我们