你真的懂TensorFlow吗?为什么会Flow?(3)

2017-05-23 编辑:

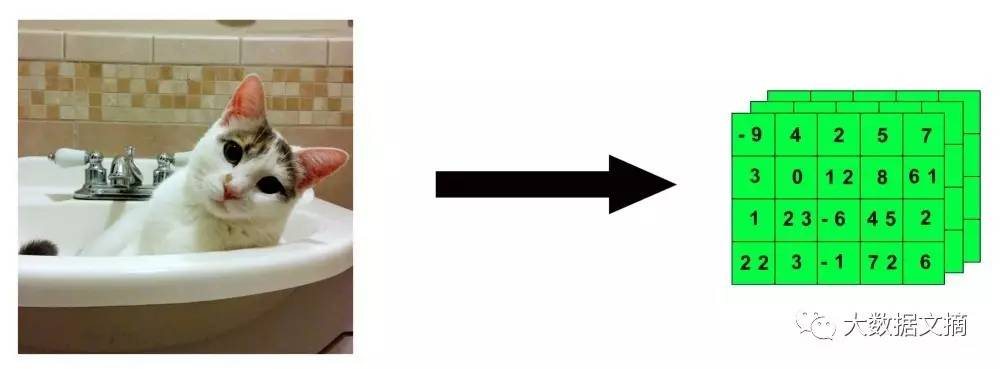

这样,我可爱的Dove将被简化为一串冷冰冰的数字,就好像它变形或流动起来了。

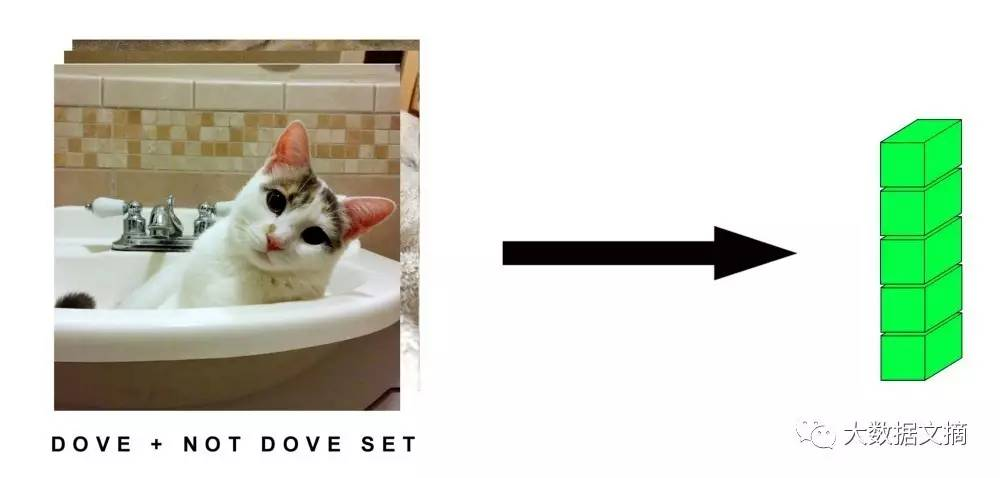

然后,如果我们有一大堆不同类型的猫咪图片(虽然都没有Dove美),也许是100,000张吧,不是DOVE它的,750 x750像素的。我们可以在Keras中用4D张量来这样定义:

(10000,750,750,3)

5D张量

5D张量可以用来存储视频数据。TensorFlow中,视频数据将如此编码:

(sample_size, frames, width, height, color_depth)

如果我们考察一段5分钟(300秒),1080pHD(1920 x 1080像素),每秒15帧(总共4500帧),颜色深度为3的视频,我们可以用4D张量来存储它:

(4500,1920,1080,3)

当我们有多段视频的时候,张量中的第五个维度将被使用。如果我们有10段这样的视频,我们将得到一个5D张量:

(10,4500,1920,1080,3)

实际上这个例子太疯狂了!

这个张量的大是很荒谬的,超过1TB。我们姑且考虑下这个例子以便说明一个问题:在现实世界中,我们有时需要尽可能的缩小样本数据以方便的进行处理计算,除非你有无尽的时间。

这个5D张量中值的数量为:

10 x 4500 x 1920 x 1080 x 3 = 279,936,000,000

在Keras中,我们可以用一个叫dype的数据类型来存储32bits或64bits的浮点数

我们5D张量中的每一个值都将用32 bit来存储,现在,我们以TB为单位来进行转换:

279,936,000,000 x 32 = 8,957,952,000,000

这还只是保守估计,或许用32bit来储存根本就不够(谁来计算一下如果用64bit来存储会怎样),所以,减小你的样本吧朋友。

事实上,我举出这最后一个疯狂的例子是有特殊目的的。我们刚学过数据预处理和数据压缩。你不能什么工作也不做就把大堆数据扔向你的AI模型。你必须清洗和缩减那些数据让后续工作更简洁更高效。

降低分辨率,去掉不必要的数据(也就是去重处理),这大大缩减了帧数,等等这也是数据科学家的工作。如果你不能很好地对数据做这些预处理,那么你几乎做不了任何有意义的事。

结论

好了,现在你已经对张量和用张量如何对接不同类型数据有了更好的了解。

下一篇“数学烂也要学AI”文章里,我们将学习如何在张量上做各种变换,这就是大家所熟知的数学。换句话说,我们将让张量“流动Flow起来”。

原文链接:https://hackernoon.com/learning-ai-if-you-suck-at-math-p4-tensors-illustrated-with-cats-27f0002c9b32

相关阅读:

相关推荐: