2.5个视角解读商汤科技@GPU技术大会(2)

2017-05-18 编辑:

首先是SenseVideo,尽管机器可以看懂行人和车辆的属性,但想要进行检索,只能输入特定的语义标签。我们无法和机器像人一样用“语言”进行沟通。这就使得SenseVideo和自然语言处理(NLP)技术的结合,显得意义十足。

“他穿着黑色的人字拖,带有白色条纹的黑色短裤,短袖圆领衬衫,还背着一个黑色的背包”。这句话听起来,更像是警察对犯罪嫌疑人的描述,但很快,警察们就不需要再靠自己查找,他们直接将这句话输入到计算机,通过NLP提取目标信息,然后由机器视觉技术,在海量的视频中进行匹配,从而锁定嫌疑人的踪迹。

视频结构化系统未来可以和自然语言处理技术相结合,以更加直观的语义描述,更便捷地找出符合特征的目标人物

至于SensePose,徐立博士的举例,不禁让人感到强烈的“发散性”思维,你会惊呼AI技术还能这样混搭运用。

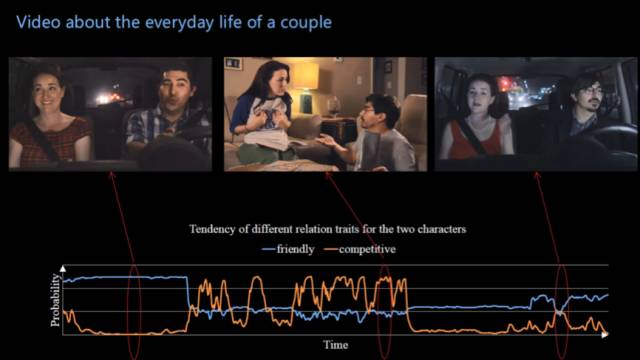

当我们想要观察两个人的关系时,可以从他们之间的动作和表情入手。两个人相拥时,可以描述为“Warm(温暖)”,两人手舞足蹈争吵时,可以描述为“Competitive(竞争)”。而将动作估计和人脸关系预测技术相结合,就可以实现这种关系特征的预测。那么这样的技术,该如何应用呢?

动作估计技术未来可与人脸预测技术相结合,用于描述视频中人物关系或人物状态,实现视频内容的理解和分析,机器将懂得人类情感

徐立博士给出的答案是——视频分析。他现场演示了一段日常生活场景中两人对话的视频。关系特征预测系统可以根据画面内容,实时分析两人是“Friendly(友好)”还是“Competitive(竞争)”,并形成描绘关系可能性的变化曲线。

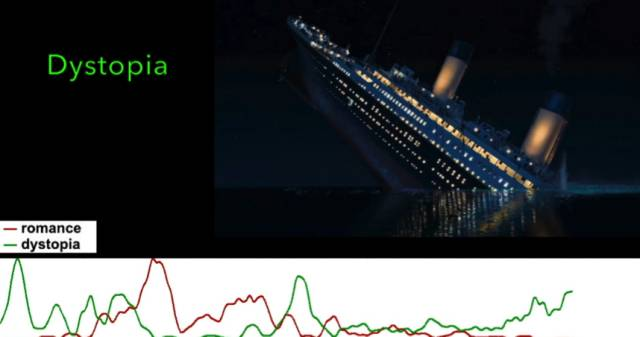

一旦这项技术大规模应用于影视行业,将实现自动化的全影片内容属性分析。比如在《泰坦尼克号》中,分析romance(浪漫)的部分和dystopia(反乌托邦)的部分,就可以建立针对每一部电影影片的内容类型库。试想,当这项技术再结合语音识别和NLP后,用户就真的可以对着电视说“给我放最浪漫的那段”了。

很难让人想到,人工智能让人类情感中最难以描述的“浪漫”也能用数据表达出来

这也正是徐立将演讲主题定为“深度视频理解”的原因。所谓“深度”,并不仅仅是提高准确率,而是建立在准确率提升的基础上,将实现怎样的全新应用模式,同时又如何影响到用户生活的每一个点滴。

Keynote:AI的“无限机遇”

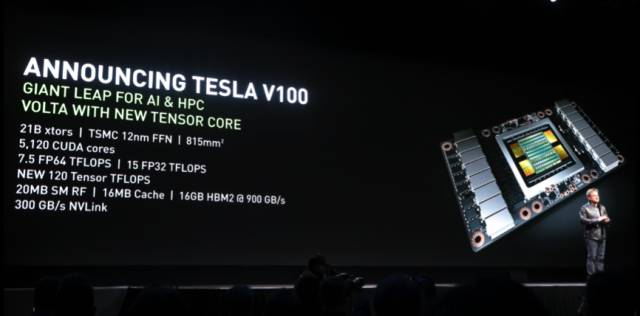

每一年GTC GPU技术大会的最大看点就是英伟达创始人、全球CEO黄仁勋的Keynote演讲。本次发布的Tesla V100,无疑再次将AI计算的性能提升了一个数量级,作为Volta GPU架构的首款产品,各领域通向AI的进程,又将再度加快一个等级。

黄仁勋在Keynote中发布Tesla V100,全新引入的Tensor Core将大大提升AI计算性能

性能永远是GPU发展的首要目标,如何利用GPU打造更生动、更浩瀚的AI应用场景,则是商汤科技等AI实践者们解决的问题。就像SensePose采用DGX-1进行了72小时的训练,便在单目摄像头上实现精准的定位结果。而SenseFace和SenseVideo能够在Jetson TX1上实现双路高清视频处理,也全然得益于商汤算法和最新GPU技术的紧密集合。

SensePose采用英伟达的DGX-1深度学习系统训练,仅需72小时就可达到我们所看到的精准动作估计效果

未来有了Volta架构的加持,对商汤科技来说,其“深度视频”技术必然还将延伸到更多的方向。作为旁观者,我们可以轻松地说出无人驾驶、医疗影像等领域,但至于如何能够以我们毫无察觉的方式,潜移默化地进行渗透,还需要让商汤科技这样的顶尖的AI企业来回答。

GTC 2017主办方 “AI计算公司” 英伟达展示区视频,展示了商汤科技智能视频产品,成为大会最受关注的亮点之一

就好像商汤科技副总裁柳钢说的那样:科学家走出学术机构,进入产业界搞创业看似“不靠谱”,实际一起“打仗”才发现,科学家比任何人都清楚今天的人工智能技术肯定会带来一场世界级的“新工业革命”。

相关阅读:

相关推荐: